Редица компании, включително Microsoft і Facebook, и дори изследователи от Университета на Южна Калифорния, разработват технологии за борба с дълбоките фалшификати и предотвратяване на разпространението им от жълтите медии и дезинформацията като цяло. Въпреки това група учени успяха да ги измамят.

Екип от компютърни учени от Калифорнийския университет в Сан Диего предупреди, че все още е възможно да се излъжат съществуващите системи за откриване на deepfake чрез вмъкване на входни данни, наречени „конкурентни примери“ във всеки видеокадър. Учените представиха своите открития на конференцията за компютърно зрение WACV 2021, проведена онлайн миналия месец.

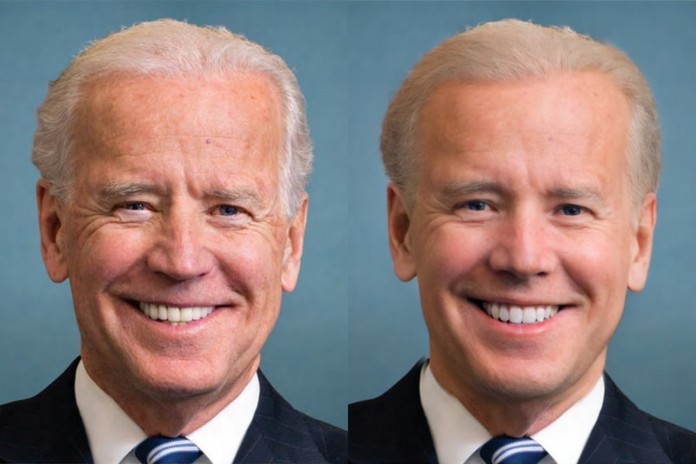

Конкурентни примери са леко променени входни данни, които карат системите с изкуствен интелект, като например модели за машинно обучение, да допускат грешки. Освен това екипът показа, че атаката все още работи след компресиране на видеото. Във видеото по-горе учените показват, че XceptionNet, детектор за дълбоки фалшификати, етикетира тяхното конкурентно видео като „истински“.

Повечето от тези детектори работят, като проследяват лица във видеоклип и изпращат данните за изрязаното лице към невронна мрежа за анализ. След това невронната мрежа ще анализира тези данни и ще намери елементи, които обикновено се възпроизвеждат лошо в дълбоки фалшификати, като например трептене.

Чрез вмъкване на конкурентни примери изследователите откриха, че могат да заблудят тези детектори за дълбоки фалшиви да повярват, че видеоклиповете са истински.

Те заявяват в документа, че „за да се използват тези детектори за дълбоки фалшиви на практика, е важно да се оценят спрямо адаптивен противник, който е наясно с тази защита и умишлено се опитва да я разбие. Ние показваме, че съвременните методи за откриване на дълбоки фалшиви фалшификати могат лесно да бъдат заобиколени, ако нападателят е напълно или дори частично запознат с детектора."

Както тези учени показаха, технологиите за автоматизация, които се разработват за борба с дезинформацията, може все още да не са на ниво.

Прочетете също: